Le paysage de l'IA a changé radicalement. En janvier 2025, DeepSeek R1 a fait irruption sur la scène — un modèle de raisonnement à poids ouverts qui a atteint les performances de classe GPT-4 tout en étant complètement auto-hébergeable. Il a envoyé des ondes de choc dans l'industrie, effaçant brièvement près de 1 000 milliards de dollars de la capitalisation boursière de Nvidia et forçant chaque équipe tech à se poser une question simple : pourquoi payons-nous encore pour l'IA cloud ?

Un an plus tard, la réponse est encore plus claire. DeepSeek R1 et ses variantes distillées fonctionnent parfaitement sur du matériel standard via Ollama. ChatGPT reste un produit cloud raffiné — mais à un coût récurrent, avec vos données transitant par les serveurs d'OpenAI.

Dans cette comparaison exhaustive, nous analyserons coût, confidentialité, performance et cas d'usage pour vous aider à décider quelle voie est la bonne pour votre équipe en 2026.

TL;DR — La comparaison rapide

| Fonctionnalité | DeepSeek R1 (Auto-hébergé) | ChatGPT (Cloud OpenAI) |

|---|---|---|

| Hébergement | Votre matériel / VPS | Serveurs OpenAI |

| Modèle de coût | Matériel unique + électricité | 20-200$/mois par utilisateur (abonnement) ou API pay-per-token |

| Confidentialité | 100% local — rien ne quitte votre réseau | Données traitées sur les serveurs OpenAI |

| Accès au modèle | Poids ouverts (licence MIT) | Propriétaire, code fermé |

| Usage hors ligne | ✅ Fonctionnalité complète hors ligne | ❌ Nécessite internet |

| Personnalisation | Fine-tuning, quantification, librement modifiable | Limité aux prompts système et GPTs |

| Qualité de raisonnement | Comparable à GPT-4o sur les benchmarks maths et code | État de l'art avec GPT-4o / o1 |

| Facilité d'installation | ~10 minutes avec Ollama | S'inscrire et c'est parti |

| Tailles de modèle | 1,5B à 671B paramètres | N/A (cloud uniquement) |

| Limites de débit | Aucune — limité uniquement par votre matériel | Limites de débit API par niveau |

Pourquoi DeepSeek R1 a tout changé

La révolution des poids ouverts

DeepSeek R1 n'était pas juste un autre modèle open source. C'était la preuve qu'un laboratoire d'IA chinois pouvait produire des capacités de raisonnement rivalisant avec le meilleur d'OpenAI — puis publier les poids gratuitement. La famille de modèles va d'une version distillée de 1,5B (fonctionne sur un Raspberry Pi) au mastodonte complet de 671B paramètres Mixture-of-Experts.

Résultats clés des benchmarks qui ont attiré l'attention :

- AIME 2024 (Maths) : DeepSeek R1 a obtenu 79,8%, comparable au o1-mini d'OpenAI

- Codeforces (Programmation compétitive) : Rating Elo de 2 029 — rivalisant avec les meilleurs compétiteurs humains

- MATH-500 : 97,3% de précision, surpassant GPT-4o

- GPQA Diamond (Science niveau master) : 71,5%, compétitif avec o1-preview

Le message était sans équivoque : vous n'avez plus besoin d'une facture API de 200$/mois pour accéder au raisonnement de pointe.

Pourquoi c'est important maintenant

En 2026, l'écosystème DeepSeek a considérablement mûri :

- Ollama fournit un déploiement en une commande pour toutes les variantes DeepSeek R1

- Modèles quantifiés (Q4_K_M, Q8) permettent au distillat 70B de fonctionner fluidement sur un MacBook Pro avec 64GB de RAM

- Open WebUI vous donne une interface type ChatGPT sur votre modèle local

- Des fine-tunes communautaires existent pour chaque domaine, du juridique au médical en passant par la revue de code

L'infrastructure est prête pour la production. La question n'est pas pouvez-vous auto-héberger — c'est pourquoi ne le feriez-vous pas ?

Comparaison des coûts : les chiffres ne mentent pas

Prix ChatGPT en 2026

La structure tarifaire d'OpenAI a évolué, mais le modèle de base reste : vous payez par utilisateur, par mois, à vie.

| Plan | Prix | Ce que vous obtenez |

|---|---|---|

| Gratuit | 0$ | Accès GPT-4o limité, débit limité |

| Plus | 20$/mois | Plus de GPT-4o, accès o1, DALL-E, navigation |

| Pro | 200$/mois | Accès illimité à tous les modèles, mode o1 Pro |

| Team | 25-30$/utilisateur/mois | Fonctionnalités workspace, contrôles admin |

| Enterprise | Personnalisé | SSO, conformité, support dédié |

Prix API (pay-per-token) :

- GPT-4o : ~2,50$/1M tokens d'entrée, ~10$/1M tokens de sortie

- o1 : ~15$/1M tokens d'entrée, ~60$/1M tokens de sortie

Pour une équipe de 10 développeurs utilisant ChatGPT Plus, c'est 2 400$/an minimum. Une utilisation intensive de l'API peut facilement pousser les coûts à 10 000-50 000$/an.

Coûts DeepSeek R1 auto-hébergé

La beauté de l'auto-hébergement : les coûts sont fixes et prévisibles.

| Configuration | Coût matériel | Coût mensuel | Niveau de performance |

|---|---|---|---|

| MacBook Pro M4 Max (128GB) | ~4 000$ (déjà en votre possession ?) | ~5$ électricité | Fait tourner le distillat 70B confortablement |

| PC avec RTX 4090 (24GB) | ~2 000$ GPU | ~10$ électricité | Fait tourner le distillat 32B à haute vitesse |

| VPS (Hetzner, 8 vCPU, 32GB) | — | ~30$/mois | Fait tourner le distillat 14B pour petite équipe |

| Serveur dual RTX 3090 | ~3 000$ total | ~20$ électricité | Fait tourner le distillat 70B, sert 5-10 utilisateurs |

| GPU Cloud (RunPod/Vast.ai) | — | ~50-150$/mois | Modèle complet 671B possible |

Comparaison des coûts annuels — ChatGPT Plus vs DeepSeek R1 auto-hébergé

Analyse du seuil de rentabilité pour une équipe de 10 personnes :

- ChatGPT Plus pour 10 utilisateurs : 200$/mois = 2 400$/an

- DeepSeek R1 auto-hébergé sur VPS Hetzner : 30$/mois = 360$/an

- Économies : 2 040$/an (85%)

Et c'est le scénario conservateur. Si votre équipe utilise intensivement l'API pour la génération de code, l'analyse de documents ou les flux automatisés, les économies se multiplient drastiquement. Avec l'auto-hébergement, 10 000 requêtes coûtent autant que 10 requêtes : coût marginal zéro.

Confidentialité : l'éléphant dans la salle serveur

C'est là que l'auto-hébergement offre son avantage le plus convaincant — et ce n'est même pas proche.

Ce qui se passe avec ChatGPT

Quand vous envoyez un prompt à ChatGPT :

- Vos données voyagent sur internet vers les serveurs d'OpenAI (hébergés sur Microsoft Azure)

- Elles sont traitées, potentiellement loggées et stockées selon les politiques de rétention de données d'OpenAI

- La politique de confidentialité d'OpenAI permet l'utilisation de vos données pour l'amélioration du modèle (sauf opt-out via paramètres API ou plan Enterprise)

- Vous êtes soumis à la juridiction américaine, peu importe où vous vous trouvez

Pour les particuliers qui chattent occasionnellement, c'est acceptable. Pour les entreprises manipulant du code propriétaire, des documents juridiques, des données de patients, des dossiers financiers ou des secrets commerciaux, c'est inacceptable.

Ce qui se passe avec DeepSeek R1 auto-hébergé

Vos données ne quittent jamais votre machine. Point.

- Les prompts sont traités localement sur votre CPU/GPU

- Aucune télémétrie, aucun logging vers des serveurs externes

- Conformité RGPD/HIPAA complète par défaut — les données restent dans votre juridiction

- Déploiement air-gapped possible pour sécurité maximale

- Vous contrôlez rétention, chiffrement et politiques d'accès

Pour les industries régulées (santé, finance, juridique, gouvernement), ce n'est pas un plus. C'est une exigence.

Flux de données — IA Cloud vs IA Auto-hébergée

Scénarios de confidentialité réels

| Scénario | ChatGPT | DeepSeek R1 Auto-hébergé |

|---|---|---|

| Révision de code source propriétaire | ⚠️ Code envoyé aux serveurs OpenAI | ✅ Reste sur votre machine |

| Analyse de dossiers médicaux patients | ❌ Risque conformité HIPAA | ✅ Entièrement conforme localement |

| Résumé de mémoires juridiques confidentiels | ⚠️ Exposition potentielle des données | ✅ Air-gappable |

| Traitement de données personnelles clients | ⚠️ Processeur de données tiers | ✅ Vous êtes le seul processeur |

| Travail sur projets classifiés | ❌ Impossible | ✅ Capable hors ligne |

Performance : comment se comparent-ils vraiment ?

Soyons honnêtes sur ce que vous obtenez avec chaque option.

Où ChatGPT (GPT-4o / o1) gagne

- ✅Capacités multimodales : compréhension d'images, génération DALL-E, mode vocal

- ✅Navigation et plugins : accès web temps réel, exécution de code

- ✅Fenêtres de contexte plus larges : jusqu'à 128K tokens avec GPT-4o

- ✅Raisonnement de pointe : o1 et o1-pro pour problèmes complexes multi-étapes

- ✅Installation zéro : fonctionne instantanément depuis n'importe quel navigateur

Où DeepSeek R1 gagne

- ✅Aucune limite de débit : générez autant de texte que votre matériel le permet

- ✅Latence consistante : pas de file d'attente, pas de messages "nous connaissons une forte demande"

- ✅Personnalisation : fine-tuning sur vos données de domaine pour performance spécialisée supérieure

- ✅Traitement par lots : traitez des milliers de documents la nuit sans coûts API

- ✅Reproductibilité : même modèle, mêmes poids, sorties déterministes

Scores benchmarks — DeepSeek R1 vs GPT-4o vs o1-mini

Comparaison benchmarks (résultats publiés 2025)

| Benchmark | DeepSeek R1 (671B) | GPT-4o | o1-mini |

|---|---|---|---|

| MATH-500 | 97,3% | 74,6% | 90,0% |

| AIME 2024 | 79,8% | 9,3% | 63,6% |

| Codeforces Elo | 2 029 | 759 | 1 820 |

| GPQA Diamond | 71,5% | 49,9% | 60,0% |

| MMLU | 90,8% | 88,7% | 85,2% |

| SWE-bench Verified | 49,2% | 38,4% | 41,6% |

Mise en garde importante : ce sont des benchmarks pour le modèle complet 671B. Si vous faites tourner une variante distillée 7B ou 14B sur du matériel modeste, attendez-vous à des scores plus bas. Le distillat 70B conserve la plupart des capacités de raisonnement et est le sweet spot pour l'auto-hébergement.

Guide installation rapide : DeepSeek R1 + Ollama + Open WebUI

Voici comment passer de zéro à votre propre assistant IA en moins de 10 minutes.

Architecture du stack IA auto-hébergé

Étape 1 : Installer Ollama

# macOS / Linux

curl -fsSL https://ollama.com/install.sh | sh

# Ou sur macOS via Homebrew

brew install ollamaÉtape 2 : Télécharger un modèle DeepSeek R1

Choisissez votre modèle selon votre matériel :

# Léger (4GB RAM minimum) — bon pour les tests

ollama pull deepseek-r1:8b

# Milieu de gamme (16GB RAM) — usage quotidien solide

ollama pull deepseek-r1:14b

# Utilisateur avancé (32-64GB RAM) — capacité de raisonnement quasi-complète

ollama pull deepseek-r1:32b

# Mode beast (64GB+ RAM ou multi-GPU) — qualité maximale

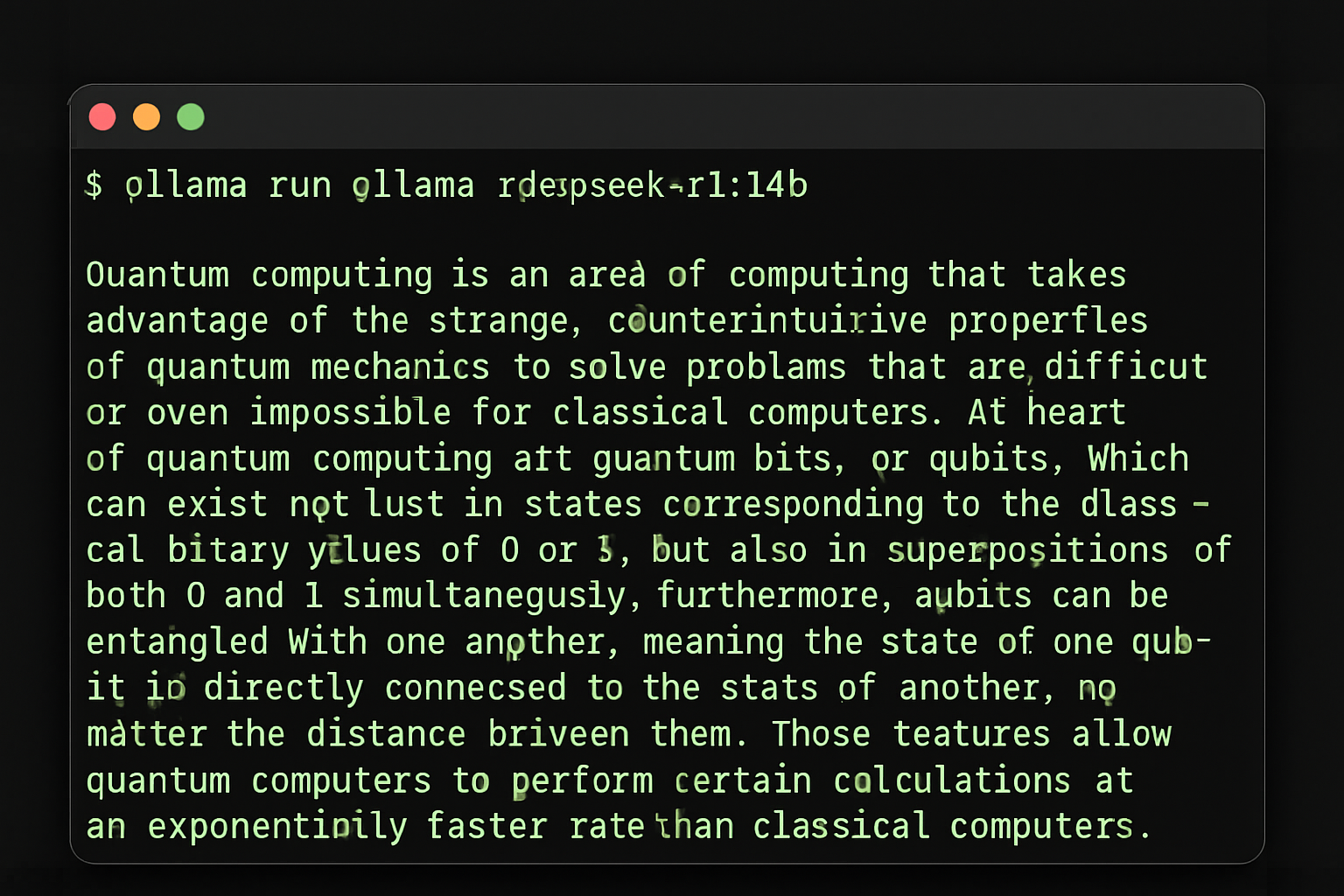

ollama pull deepseek-r1:70bÉtape 3 : Tester en terminal

ollama run deepseek-r1:14b

Ollama exécutant DeepSeek R1 — une seule commande pour commencer

Vous pouvez commencer à chatter immédiatement. Tapez vos questions et obtenez des réponses localement !

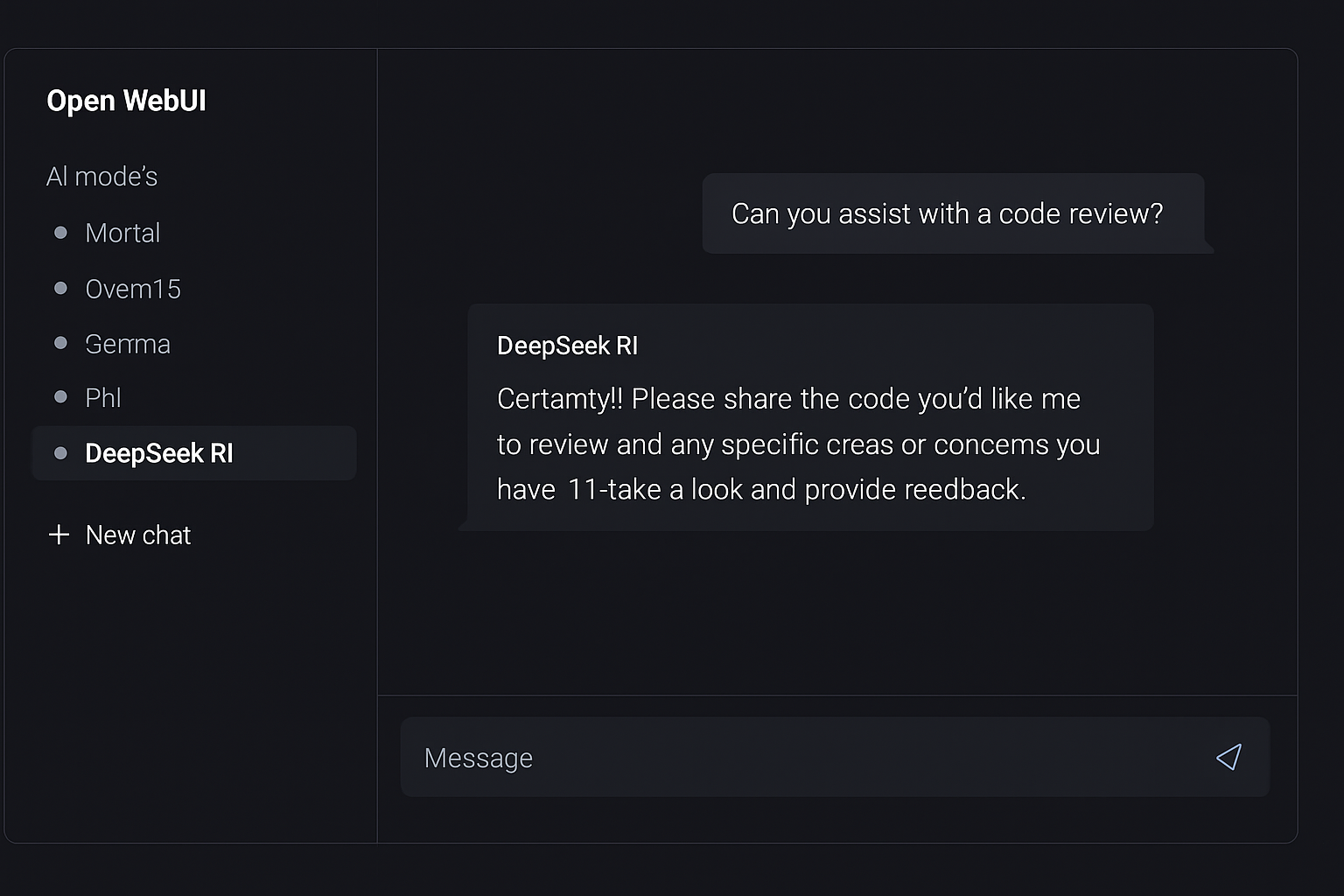

Étape 4 : Ajouter Open WebUI pour interface type ChatGPT

# Avec Docker (recommandé)

docker run -d \

--name open-webui \

-p 3000:8080 \

-v open-webui:/app/backend/data \

--add-host=host.docker.internal:host-gateway \

-e OLLAMA_BASE_URL=http://host.docker.internal:11434 \

--restart always \

ghcr.io/open-webui/open-webui:main

Open WebUI — une interface type ChatGPT pour votre IA locale

Maintenant ouvrez http://localhost:3000 dans votre navigateur. Créez un compte (c'est local — le premier utilisateur devient admin), sélectionnez votre modèle DeepSeek R1 et commencez à chatter.

Étape 5 : Exposer à votre équipe (optionnel)

Si vous voulez partager avec des collègues, configurez un reverse proxy :

server {

listen 443 ssl;

server_name ai.votreentreprise.com;

ssl_certificate /chemin/vers/cert.pem;

ssl_certificate_key /chemin/vers/key.pem;

location / {

proxy_pass http://localhost:3000;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

}

}Votre équipe a maintenant un assistant IA privé et auto-hébergé avec une interface web soignée. Temps d'installation total : ~10 minutes.

Cas d'usage : quand choisir quoi

Choisissez ChatGPT quand :

- 🔵Vous avez besoin d'IA multimodale (analyse d'images, voix, DALL-E)

- 🔵Vous voulez zéro maintenance et accès instantané

- 🔵Vous êtes utilisateur solo avec usage modéré (~20$/mois c'est OK)

- 🔵Vous avez besoin de navigation web temps réel intégrée dans les réponses

- 🔵Vous avez besoin du dernier modèle (OpenAI sort des mises à jour hebdomadaires)

- 🔵Vous construisez des prototypes et voulez commencer immédiatement

Choisissez DeepSeek R1 auto-hébergé quand :

- 🟢La confidentialité des données n'est pas négociable (industries régulées, code propriétaire)

- 🟢Vous avez une équipe de 3+ (les coûts évoluent de façon plate, pas par utilisateur)

- 🟢Vous traitez de gros volumes (analyse par lots, pipelines automatisés)

- 🟢Vous avez besoin de capacité hors ligne (environnements air-gapped, voyages)

- 🟢Vous voulez fine-tuner le modèle sur vos données de domaine

- 🟢Vous construisez de l'IA dans votre produit (pas de dépendance API)

- 🟢Vous voulez des coûts prévisibles (pas de factures surprise)

- 🟢Vous avez besoin de performance consistante (pas de limitation de débit ou temps d'arrêt)

L'approche hybride

Beaucoup d'équipes en 2026 font tourner les deux : DeepSeek R1 localement pour l'assistance quotidienne au codage, la révision de documents et le traitement par lots — tout en gardant un abonnement ChatGPT Pro pour les tâches multimodales occasionnelles et l'accès aux modèles de pointe. Cela vous donne le meilleur des deux mondes tout en minimisant les coûts cloud.

Exigences matérielles par taille de modèle

Choisissez la bonne variante DeepSeek R1 pour votre matériel :

Tailles de modèle DeepSeek R1 — du 7B au 671B

| Taille modèle | RAM requise | Mémoire GPU | Niveau performance | Meilleur pour |

|---|---|---|---|---|

| 1,5B | 2GB | Optionnel | Raisonnement basique, réponses rapides | Appareils IoT, tests |

| 7B | 8GB | 6GB VRAM (optionnel) | Bonnes capacités générales | Usage personnel, charges légères |

| 14B | 16GB | 12GB VRAM (optionnel) | Bon raisonnement, aide codage | Équipes dev, usage quotidien |

| 32B | 32GB | 24GB VRAM (recommandé) | Excellent raisonnement et codage | Équipes pro, tâches complexes |

| 70B | 64GB | 48GB+ VRAM (recommandé) | Capacité quasi-modèle-complet | Recherche, usage entreprise |

| 671B | 500GB+ | Configuration multi-GPU requise | Capacité maximale | Institutions recherche uniquement |

Recommandations VPS :

- Hetzner CCX33 (8 vCPU, 32GB RAM) : Parfait pour modèle 14B, ~35€/mois

- Hetzner CCX53 (16 vCPU, 64GB RAM) : Fait bien tourner modèle 32B, ~70€/mois

- Instances GPU OVHcloud : Pour inférence accélérée GPU, ~80-150€/mois

Vue d'ensemble : pourquoi l'auto-hébergement IA compte

Le passage vers l'IA auto-hébergée ne concerne pas que les économies. Il s'agit de souveraineté.

Quand vous dépendez d'un fournisseur d'IA cloud, vous êtes soumis à :

- Changements de prix — OpenAI a augmenté les prix avant, et le fera encore

- Changements de politique — Les conditions de service peuvent changer du jour au lendemain

- Décisions de censure — Ce dont le modèle discutera et ce qu'il ne dira pas

- Disponibilité — Les pannes arrivent, les limites de débit se resserrent

- Risque géopolitique — L'accès peut être restreint par région

- Mises à jour de modèles — Votre version de modèle favorite pourrait être retirée

Avec des modèles auto-hébergés, vous possédez votre stack IA. Vous choisissez quel modèle faire tourner, comment il se comporte, quelles données il voit, et quand upgrader. Ce n'est pas qu'un avantage technique — c'est un avantage stratégique.

Conclusion : le mouvement intelligent en 2026

Il y a un an, auto-héberger l'IA était une expérience pour passionnés. Aujourd'hui, c'est une stratégie prête pour production utilisée par startups, entreprises et développeurs indépendants dans le monde entier.

DeepSeek R1 offre des capacités de raisonnement qui rivalisent avec — et dans certains benchmarks dépassent — ChatGPT. Ollama rend le déploiement trivial. Open WebUI vous donne une interface soignée. Et vous gardez chaque byte de données sous votre contrôle.

Le calcul est simple :

- Équipe de 10 personnes sur ChatGPT Plus : 2 400$/an

- Équipe de 10 personnes sur DeepSeek R1 auto-hébergé : 360$/an

- Économies annuelles : 2 040$ — plus souveraineté complète des données

ChatGPT reste un excellent produit. Mais quand vous pouvez égaler ses capacités principales à une fraction du coût tout en gardant vos données privées, le mouvement intelligent est clair.

La révolution auto-hébergée n'arrive pas — elle est là. La question est : votre équipe mènera-t-elle la charge, ou regardera-t-elle depuis les lignes de côté ?

Prêt à explorer plus d'outils IA auto-hébergés ? Parcourez notre répertoire curé d'applications auto-hébergeables sur hostly.sh — des assistants IA aux plateformes d'automatisation, nous vous aidons à trouver les meilleurs logiciels open source à faire tourner sur votre propre infrastructure.

Besoin d'un VPS puissant pour charges de travail IA ? Consultez nos plans d'hébergement optimisés spécialement conçus pour applications machine learning et IA. Commencez avec DeepSeek R1 sur un serveur prêt pour production en minutes.

Cette comparaison vous a été utile ? Consultez nos autres guides sur alternatives auto-hébergées aux outils SaaS populaires.